Los padres advirtieron sobre un inquietante plan de secuestro utilizando réplicas de voz de niños

Las estafas telefónicas existen desde hace tiempo, pero los avances recientes en tecnología de inteligencia artificial está facilitando que los malos actores convenzan a las personas de que han secuestrado a sus seres queridos.

Los estafadores están utilizando IA para replicar las voces de los familiares de las personas en esquemas de secuestro falsos que convencen a las víctimas de enviar dinero a los estafadores a cambio de la seguridad de sus seres queridos.

El plan recientemente apuntó a dos víctimas en un distrito escolar del estado de Washington.

Las Escuelas Públicas de Highline en Burien, Washington, emitieron un aviso el 25 de septiembre alertando a los miembros de la comunidad que los dos individuos fueron atacados por “estafadores que afirmaban falsamente que habían secuestrado a un miembro de la familia”.

¿PUEDE LA IA AYUDAR A ALGUIEN A REALIZAR UNA ESTAFA DE SECUESTRO FALSO CONTRA USTED O SU FAMILIA?

Los estafadores están utilizando IA para manipular las voces reales de las personas en un esfuerzo por engañar a las víctimas haciéndoles creer que sus seres queridos han sido secuestrados para pedir un rescate. (Helena Dolderer/Picture Alliance)

“Los estafadores jugaron [AI-generated] grabación de audio del miembro de la familia, luego exigió un rescate”, escribió el distrito escolar. “La Oficina Federal de Investigaciones (FBI) ha notado un aumento a nivel nacional en estas estafas, con un enfoque particular en familias que hablan un idioma distinto al inglés. “

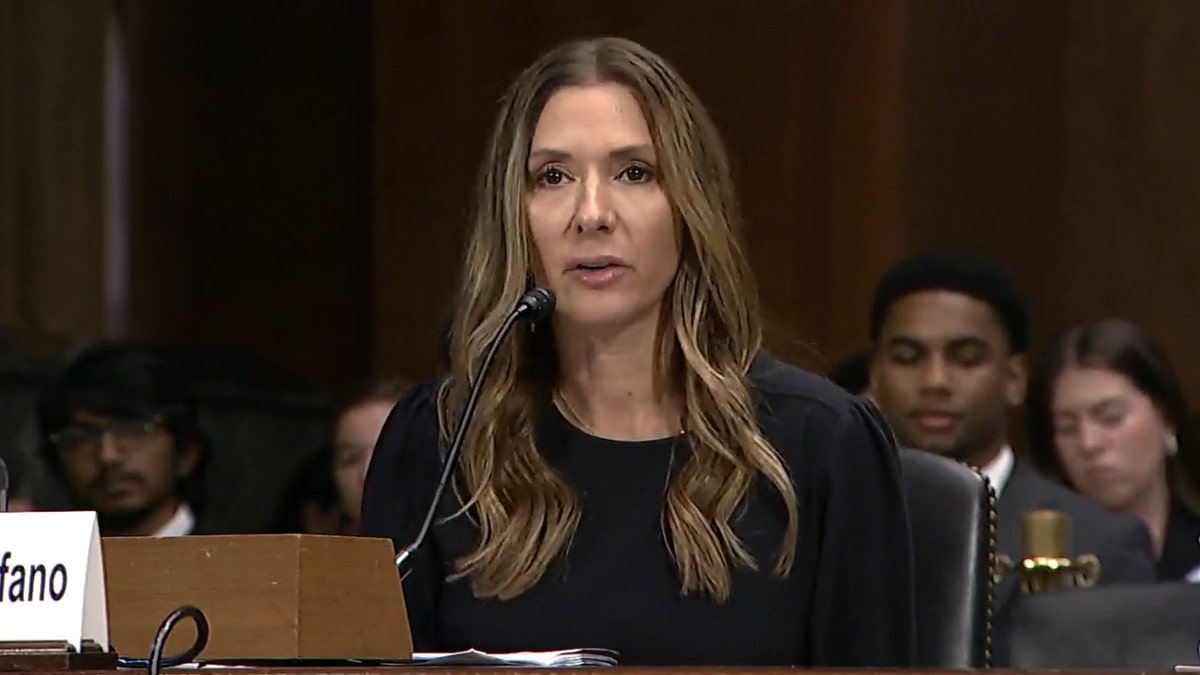

En junio, la madre de Arizona, Jennifer DeStefano, testificó ante el Congreso sobre cómo los estafadores utilizaron la IA para hacerle creer que su hija había sido secuestrada en un complot de extorsión de 1 millón de dólares. Comenzó explicando su decisión de contestar una llamada de un número desconocido un viernes por la tarde.

“Contesté el teléfono ‘Hola’. En el otro extremo estaba nuestra hija Briana sollozando y llorando diciendo: ‘Mamá'”, escribió DeStefano en su testimonio ante el Congreso. “Al principio, no pensé en nada… Casualmente le pregunté qué había pasado mientras la tenía en el altavoz caminando por el estacionamiento para encontrarse con su hermana. Briana continuó diciendo: ‘Mamá, lo arruiné’, con más llantos y sollozos. “.

En ese momento, DeStefano no tenía idea de que un mal actor había usado IA para replicar la voz de su hija en la otra línea.

MIRA EL TESTIMONIO DE DESTEFANO:

Luego escuchó la voz de un hombre al otro lado de la línea gritándole demandas a su hija, mientras Briana (al menos su voz) continuaba gritando que hombres malos se la habían “llevado”.

“Briana estaba al fondo suplicando desesperadamente: ‘¡Mamá, ayúdame!'”

“Un hombre amenazador y vulgar se hizo cargo de la llamada. ‘Escucha, tengo a tu hija, díselo a cualquiera, llama a la policía, le voy a bombear el estómago tan lleno de drogas, voy a hacer lo que quiera con ella’. , déjala adentro [M]¡Éxico y nunca la volverás a ver!’ Todo el tiempo Briana estaba en el fondo suplicando desesperadamente: ‘¡Mamá, ayúdame!'”, escribió DeStefano.

Los hombres exigieron un rescate de $1 millón a cambio de la seguridad de Briana mientras DeStefano intentaba contactar a amigos, familiares y policía para ayúdala a localizar a su hija. Cuando DeStefano les dijo a los estafadores que no tenía $1 millón, exigieron $50,000 en efectivo para ser recogidos en persona.

Mientras se llevaban a cabo estas negociaciones, el esposo de DeStefano localizó a Briana a salvo en su casa en su cama sin conocimiento de la estafa que involucraba su propia voz.

En ese momento, Jennifer DeStefano no tenía idea de que un mal actor había usado IA para replicar la voz de su hija en la otra línea. (Senado de EE. UU.)

“¿Cómo podía estar segura con su padre y aún así estar en posesión de secuestradores? No tenía ningún sentido. Tenía que hablar con Brie”, escribió DeStefano. “No podía creer que estuviera a salvo hasta que escuché su voz decir que sí. Le pregunté una y otra vez si realmente era ella, si estaba realmente a salvo, de nuevo, ¿es realmente Brie? ¿Estás segura de que estás realmente a salvo? ?! Mi mente daba vueltas. No recuerdo cuántas veces necesité consuelo, pero cuando finalmente me di cuenta de que ella estaba a salvo, me puse furioso”.

DeStefano concluyó su testimonio señalando cómo la IA está haciendo que sea más difícil para los humanos creer lo que ven y escuchar con sus propios oídos, particularmente en entornos virtuales o por teléfono.

Los malos actores han atacado a víctimas en todo Estados Unidos y en todo el mundo. Son capaces de replicar la voz de una persona a través de dos tácticas principales: primero, recopilando datos de la voz de una persona si responde a una llamada desconocida de estafadores, quienes luego usarán IA para manipular esa misma voz y decir oraciones completas; y segundo, recopilando datos de la voz de una persona a través de videos públicos publicados en las redes sociales.

“Cuanto más hablas, más datos recopilan”.

Así lo afirma Beenu Arora, director ejecutivo y presidente de Cyble, una empresa de ciberseguridad que utiliza soluciones impulsadas por IA para detener a los malos actores.

“Así que básicamente estás hablando con ellos, asumiendo que hay alguien tratando de tener una conversación, o… una llamada de telemercadeo, por ejemplo. La intención es obtener los datos correctos a través de tu voz, que ellos pueden ir e imitar… a través de algún otro modelo de IA”, explicó Arora. “Y esto se está volviendo mucho más prominente ahora”.

MIRAR: VÍCTIMA DE SECUESTRO CIBERNÉTICO ADVIERTE A PADRES

Añadió que “extraer audio de un vídeo” en las redes sociales “no es tan difícil”.

“Cuanto más hablas, más datos recopilan”, dijo Arora sobre los estafadores, “y también menos modulaciones de voz y tu jerga y tu forma de hablar. Pero… cuando recibes estas llamadas fantasmas o llamadas en blanco, yo De hecho recomiendo no hablar mucho.”

Los Institutos Nacionales de Salud (NIH) recomiendan que las víctimas del delito tengan cuidado con las llamadas que exigen dinero de rescate desde códigos de área desconocidos o números que no sean el teléfono de la víctima. Estos malos actores también hacen “grandes esfuerzos” para mantener a las víctimas al teléfono para que no tengan la oportunidad de comunicarse con las autoridades. También exigen con frecuencia que el dinero del rescate se envíe a través de un servicio de transferencia bancaria.

La agencia también recomienda que las personas objetivo de este delito intenten frenar la situación, soliciten hablar directamente con la víctima, soliciten una descripción de la víctima, escuchen atentamente la voz de la víctima e intenten comunicarse con la víctima por separado mediante llamadas, mensajes de texto o mensaje directo.

Cualquier persona que crea que ha sido víctima de este tipo de estafa debe comunicarse con el departamento de policía local. (Kurt “CyberGuy” Knutsson)

El NIH publicó un anuncio de servicio público diciendo que varios empleados del NIH han sido víctimas de este tipo de estafa, que “normalmente comienza con una llamada telefónica diciendo que su familiar está cautivo”. Anteriormente, los estafadores alegaban que un familiar de la víctima había sido secuestrado, a veces con el sonido de gritos de fondo de una llamada telefónica o un mensaje de video.

Sin embargo, más recientemente, debido a los avances en la inteligencia artificial, los estafadores pueden replicar la voz de un ser querido usando videos en las redes sociales para hacer que el complot de secuestro parezca más real. En otras palabras, los malos actores pueden usar IA para replicar la voz de un ser querido, usando videos disponibles públicamente en línea, para hacer que sus objetivos crean que sus familiares o amigos han sido secuestrados.

Las personas que llaman generalmente brindan a la víctima información sobre cómo enviar dinero a cambio del regreso seguro de su ser querido, pero los expertos sugieren que las víctimas de este delito se tomen un momento para hacer una pausa y reflexionar sobre si lo que escuchan a través de la otra línea es real. incluso en un momento de pánico.

HAGA CLIC AQUÍ PARA OBTENER LA APLICACIÓN FOX NEWS

“Mi humilde consejo… es que cuando seas tan amable[s] de mensajes alarmantes, o alguien está tratando de presionarlo o hacer cosas [with a sense] “Creo que, como sociedad, será mucho más difícil identificar lo real y lo falso debido al avance que estamos viendo”.

Arora agregó que, si bien se utilizan algunas herramientas centradas en la IA para identificar y combatir de manera proactiva las estafas de IA, debido al rápido ritmo de desarrollo de esta tecnología, quienes trabajan para evitar que los malos actores se aprovechen de víctimas desconocidas tienen un largo camino por recorrer. Cualquier persona que crea que ha sido víctima de este tipo de estafa debe comunicarse con el departamento de policía local.